Machine Learning 学习笔记 1

目录

机器学习第一周笔记

概述

什么是机器学习?

从字面上来说,机器学习就是让机器通过模仿人学习的过程学习。也就是说让机器有能力学习,而不是通过准确的程序而实现。我们生活中无处不在存在着机器学习的应用,例如垃圾邮件分类系统,通过图片识别物体等。

机器学习的分类

机器学习分为两大类:

-

有监督学习(supervised learning):给定输入数据和正确的输出结果,通过一系列“训练模型”使得输出结果和正确输出结果无限接近的过程。其中又可以分为两大类 回归(regression) 和 分类(classification) 问题。例如:给定某地区房屋的情况(房间个数,地理位置,周围环境…)及价格,来预测这个地区某个房子的价格。这就是一个回归问题。再比如通过一个人的照片来预测这个人的年龄。 而分类问题则是输出结果只有两种情况的问题。比如:预测一个病人的肿瘤是良性还是恶性;预测一封邮件是否是垃圾邮件等等。这种问题的结果只有两种情况。

-

无监督学习(unsupervised learning):没有给出正确的输出结果,让机器自己发现输入数据的结构。无监督学习最常见的应用就是分类。比如:给定用户数据,自动划分用户类比从而划分市场;给定一些文章报道,分类文章的类别,政治新闻,经济新闻,或文化新闻等等。

线性回归

回归模型

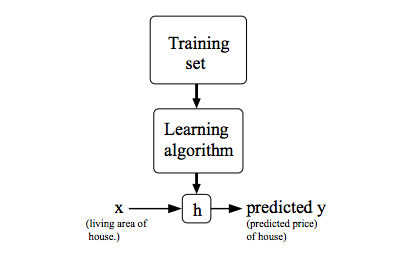

通过训练数据集(training set)学习得到一个函数h(x),使得输入数据X通过h函数映射的预测结果Y最接近正确值。线性回归的目标就是寻找到h函数使得其完美拟合输入X和输出Y的关系。

(Figure 1 https://www.coursera.org/learn/machine-learning/supplement/cRa2m/model-representation)

既然已经有了这个模型我们下一个问题就是如何才能找到这样的一个h函数?

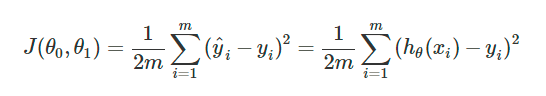

在线性回归里用来判断拟合函数h好坏的一个标准就是代价函数(Cost funtion)。这个函数的数学表示如下,其中用均方误差来表示预测结果与真实结果的误差。

这时,机器学习过程的目标就是要找到一个h函数使得误差J最小。

梯度下降(Gradient descent)

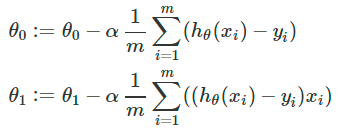

求解最小代价函数的方法之一就是用梯度下降(Gradient descent)的方法。

数学上,梯度方向是函数值下降最为剧烈的方向。那么,沿着梯度方向走,我们就能接近其最小值,或者极小值,从而接近更高的预测精度。其数学表达如下:

其中学习率ɑ表示的是下降的速率,当这个值过大时会导致错过最小值(步子跨的太大);当这个值过小时会导致下降的速度很慢(步子跨的太小)。

用梯度下降的方法就是不断的沿着梯度方向更新值,直到找到最小值。